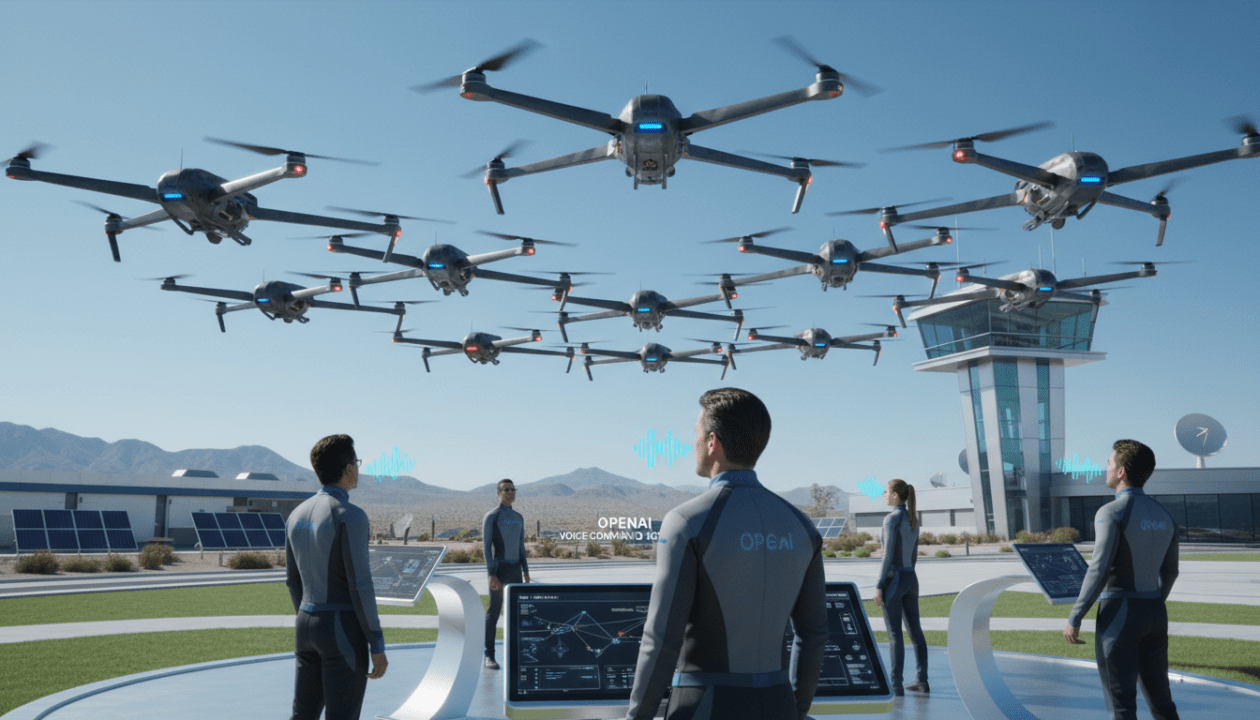

En bref : ce qu’il faut retenir sur OpenAI et la commande vocale d’une ruche de drones aux États-Unis

- OpenAI fournit la technologie de commande vocale pour un essai de ruche de drones aux États-Unis, visant des opérations coordonnées en temps réel.

- Objectif central : des ordres naturels, robustes au bruit, qui se traduisent en actions sûres pour des drones opérant en essaim.

- La reconnaissance vocale et la synthèse reposent sur des modèles audio temps réel, inspirés de GPT-4o et du Voice Engine.

- Cas d’usage testés : secours, inspection d’infrastructures, surveillance d’incendies, logistique portuaire.

- Priorités affichées : sécurité, résilience réseau, conformité FAA, et garde-fous d’intelligence artificielle responsable.

Le programme d’essai déployé sur un site fédéral américain réunit régulateurs, industriels et chercheurs autour d’un défi clair : prouver qu’une commande vocale fiable peut piloter une ruche de drones dans des conditions réelles. Grâce à OpenAI, la chaîne audio passe de la voix au plan d’action avec une latence mesurée et une sémantique interprétable. Le dispositif cherche la bonne articulation entre sécurité aérienne, efficacité opérationnelle et ergonomie pour l’humain au centre. D’un côté, la reconnaissance vocale doit encaisser le vent, les sirènes et les accents. De l’autre, les agents décisionnels doivent comprendre l’intention et borner les actions selon des règles strictes. L’ensemble promet une innovation décisive si la démonstration tient ses promesses sur la durée et si les garde-fous restent solides dans les phases les plus intenses.

OpenAI et la commande vocale d’une ruche de drones: cadre, enjeux et périmètre de l’essai aux États-Unis

Le test grandeur nature met la barre haut. Il réunit un poste de commandement mobile, un réseau cellulaire redondé, et une dizaine d’aéronefs répartis par rôles. Ce dispositif permet d’observer comment la technologie d’OpenAI transforme un ordre parlé en stratégie de déploiement. Les opérateurs gardent la main et valident chaque étape critique, avec des scénarios inspirés de missions réelles. On y trouve la cartographie rapide d’une zone inondée et la surveillance de points chauds lors d’un départ de feu.

Le terme ruche de drones désigne ici une architecture en essaim, où chaque unité coopère via un protocole anti-collision et un plan de secteur. Les consignes vocales ne remplacent pas la conception de mission, mais elles accélèrent les itérations. Par exemple, un superviseur peut dire : « Équipe Bravo, élargissez la recherche deux pâtés de maisons vers l’ouest », et l’IA recalcule aussitôt les trajectoires.

Pourquoi une commande vocale dans un tel contexte ? Parce que le temps compte en urgence, et que les mains de l’opérateur restent souvent prises par d’autres instruments. Avec l’audio, il s’affranchit d’un clavier, et il conserve la conscience de la scène. Le moteur d’intelligence artificielle doit alors interpréter l’intention, vérifier les zones interdites, et découper l’instruction en micro-actions sûres.

Paramètres opérationnels et métriques d’évaluation

La réussite ne tient pas qu’à la vitesse de la reconnaissance vocale, même si elle compte. Les équipes mesurent la latence de bout en bout, la précision de l’intent, et la résilience quand le réseau vacille. Un mode dégradé s’active dès que la 5G chute, avec un relais via edge computing au sol. Les retours d’état doivent, eux, rester clairs et concis.

Un point clé se joue sur les garde-fous. L’essai exige que chaque action de l’essaim respecte des règles aériennes et des périmètres de sécurité. Une instruction ambigüe se voit reformulée par l’IA avant exécution. En cas de doute, l’agent bloque l’ordre et demande une clarification.

De l’intention à l’action: une grammaire tactique parlée

Pour accepter la voix sur le terrain, il faut construire une grammaire commune. L’équipe conçoit un vocabulaire d’énoncés, avec des verbes d’actions et des zones définies. Des alias se créent pour éviter les confusions. Ainsi, « Balayer secteur Delta » déclenche un pattern partagé par tous les opérateurs.

L’ambition dépasse la démonstration. Si la pipeline tient, cette innovation pourrait essaimer dans d’autres centres. Les premiers résultats guideront les prochains volets réglementaires et industriels. L’ultime mesure de succès restera toutefois simple : la sécurité partout, tout le temps.

Cette première séquence pose la scène technique et humaine. Le volet suivant explore la pile audio temps réel et la façon dont elle résout la contrainte de latence.

Une autre source d’intérêt porte sur la robustesse aux bruits et sur le chaînage des décisions. Ces aspects structurent l’architecture présentée ci-dessous.

Architecture audio temps réel: reconnaissance vocale, compréhension et exécution sécurisée

Le pipeline vocal s’organise en trois couches. La première transcrit la parole avec un modèle de reconnaissance vocale robuste au vent, aux sirènes et aux communications radio. La seconde extrait l’intention et la structure en plan d’actions. La troisième la traduit en commandes sûres, priorisées selon le niveau de risque et la proximité d’obstacles.

Dans cet essai, la priorité porte sur la latence et la fiabilité. Les composants inspirés de GPT-4o et du Voice Engine gèrent l’audio bidirectionnel. Ils fournissent des réponses parlées, courtes et ciblées. Les drones reçoivent ainsi des ordres concis, et l’opérateur entend des confirmations claires.

Edge, cloud et chemins de secours

La chaîne répartit la charge entre cloud et edge. Les modules critiques se trouvent près du terrain, dans une baie GPU mobile. En cas de rupture réseau, un cache local conserve les cartes et les règles. Le système coupe toute action non vérifiable et passe en mode observation.

Par sécurité, chaque commande reçoit un identifiant traçable. Les logs permettent un audit a posteriori. Les opérateurs peuvent rejouer la séquence et comprendre pourquoi une trajectoire a été choisie. Cette transparence nourrit la confiance et accélère l’amélioration continue.

Latence, niveau de risque et lieu de calcul

Les équipes suivent une matrice qui marie délai acceptable et sensibilité de la décision. Les ordres à haut risque exigent plus de validations, mais ils restent utilisables par la voix. La table ci-dessous illustre ces compromis mesurés sur le site d’essai.

| Niveau décisionnel | Latence cible | Exemple d’ordre | Niveau de risque | Lieu de calcul |

|---|---|---|---|---|

| Tactique immédiat | < 300 ms | « Stop, altitude 50 m » | Élevé | Edge embarqué/sol |

| Réallocation locale | 0,5–1 s | « Drones 2 et 3, balayage secteur B » | Moyen | Edge + cache |

| Planification de zone | 1–3 s | « Étendre recherche vers l’ouest » | Moyen | Cloud prioritaire |

| Rapports et synthèses | 3–5 s | « Donne la carte thermique » | Faible | Cloud |

Cette stratification garde le contrôle humain au centre. Elle évite aussi les effets de bord quand la charge réseau grimpe. Les confirmations vocales restent brèves : moins de cinq secondes pour un résumé utile.

Parole naturelle et contraintes métier

La syntaxe naturelle s’accompagne de contraintes. Le modèle filtre les mots sensibles et bloque les demandes hors périmètre. Il reformule chaque intention en langage opérationnel partagé. Par exemple, « Ouvre un corridor » devient un set de waypoints conformes aux géo-fences.

Cette conciliation entre naturel et conformité démontre la maturité de l’intelligence artificielle appliquée. La voix ne remplace pas la doctrine, elle la rend actionnable à vitesse terrain. C’est l’insight clé de ce volet.

Avec cette mécanique établie, la question suivante porte sur la valeur sur le terrain. Les scénarios d’usage vont éclairer l’intérêt concret pour les équipes mixtes.

Ces démonstrations illustrent l’écart entre un proof-of-concept et une capacité répétable. Elles guident également la formation des opérateurs.

Cas d’usage concrets: secours, inspection et gestion d’incidents avec une ruche de drones à commande vocale

Sur un incendie de végétation, la voix raccourcit chaque boucle décisionnelle. Un chef de mission appelle un balayage en ligne, et l’essaim cartographie l’extension du front. La commande vocale devient un multiplicateur d’attention, car elle libère les mains pour d’autres tâches critiques.

Pour un pont soumis à une crue, l’essaim exécute une inspection en berceaux. L’opérateur dicte la cadence et la distance aux câbles porteurs. Les drones renvoient une imagerie thermique et RGB. Un rapport oral signale les anomalies prioritaires.

Recherche et sauvetage: des secondes qui comptent

Lorsqu’une personne manque à l’appel, l’équipe lance une grille de recherche. La voix règle la largeur de pas et l’altitude selon la végétation. Un « marque cet endroit » crée un point d’intérêt partagé. Le retour audio propose des pistes et aligne les équipes au sol.

L’innovation apparaît dans la boucle audio courte. Les propositions de trajectoires arrivent parlées, en langage simple. Les alertes critiques montent en priorité et interrompent toute phrase non essentielle.

Surveillance portuaire et logistique

La nuit, un port teste des rondes automatiques. La voix autorise un détour sécurisé vers une zone chargée. Le système réévalue les collisions possibles avec des grues et des mâts. Une confirmation verbale liste les obstacles majeurs avant l’action.

Les bénéfices dépassent la vitesse. La traçabilité par la voix documente la décision. On sait qui a demandé quoi, quand, et pourquoi l’ordre a été validé.

Exemple fil rouge: SkyCounty Fire District

Dans une simulation, le district SkyCounty combine des équipes au sol et une ruche de drones. Un opérateur vocal demande un corridor d’évacuation. L’essaim repère les voies libres et guide les camions. Un rapport oral final donne la couverture, la durée et les zones à risque.

Cette granularité prouve que la voix convient aux environnements bruyants, si l’architecture absorbe le chaos sonore. Elle ouvre une ergonomie plus naturelle, sans sacrifier la discipline du protocole.

Au-delà des opérations, restent les questions d’éthique, de sécurité et de cadre légal. Le prochain volet détaille ces garde-fous indispensables.

Garde-fous, sécurité et conformité: faire dialoguer IA responsable et régulation aérienne

La technologie n’a de valeur que bien bornée. L’intelligence artificielle doit prouver une sécurité intrinsèque, et la voix doit tenir face aux attaques. Des tests d’usurpation évaluent la résistance aux voix clonées. Des contrôles de vivacité audio renforcent le pipeline.

Sur le plan réglementaire américain, l’essai s’aligne sur des exemptions encadrées et sur les règles de détection et évitement. La commande vocale n’exonère pas l’opérateur de sa responsabilité. Au contraire, elle formalise la traçabilité.

Protection des données et usage responsable

Les échanges audio restent chiffrés bout à bout. Les données sensibles suivent un cycle de rétention court. Les jeux d’entraînement privilégient l’anonymisation. Cette hygiène limite l’exposition et renforce la confiance des partenaires publics.

Une gouvernance claire s’impose. Un comité examine les incidents, et il publie des correctifs de règles. Chaque nouvelle capacité vocale passe par une évaluation d’impact. Cela évite les dérives et les angles morts.

Checklist pratique avant déploiement

- Authentification vocale avec détection de relecture et de synthèse.

- Politiques de géo-fencing testées en conditions réelles.

- Modes dégradés documentés pour la perte réseau.

- Auditabilité des commandes et journaux signés.

- Formation axée sur la grammaire opérationnelle parlée.

Cette liste ne suffit pas seule. Elle sert de point de départ pour des audits continus. Les équipes mettent à jour les règles au fil des retours terrain.

Interopérabilité et transparence

Dans un écosystème multi-fournisseurs, l’API doit s’ouvrir. Les formats de journaux et de cartes restent standards. L’interopérabilité simplifie les enquêtes et les rétrofits. La transparence des modèles, elle, facilite les vérifications indépendantes.

Au final, la sécurité se fabrique au quotidien. Elle ne s’achète pas sur étagère. Ce principe guide l’essai et prépare une adoption durable.

Les garanties posées, le marché et la chaîne de valeur s’activent. La question devient alors : qui adoptera vite, et à quel coût total ?

Marché, écosystème et feuille de route: de l’essai à l’industrialisation de la ruche de drones à voix

Un succès sur le site pilote attirerait les acteurs des services publics, des utilities et de la logistique. Le coût total d’appropriation dépendra du matériel audio durci, de la connectivité et des intégrations logicielles. La valeur se mesurera sur la réduction de temps d’intervention et sur la baisse d’incidents.

Les concurrents ne restent pas immobiles. Des laboratoires testent aussi la voix, parfois avec des modèles propriétaires. L’atout d’OpenAI réside dans la maîtrise du bout en bout audio et dans la qualité conversationnelle. Les clients demanderont toutefois des garanties d’export et de support long terme.

Chaîne d’intégration et partenaires

Les intégrateurs aériens lient l’API vocale aux systèmes de gestion d’opérations. Les développeurs construisent des connecteurs vers les SIG et les jumeaux numériques. Les opérateurs forment des binômes voix-gestuelle pour travailler en radio saturée. Les fabricants, enfin, optimisent l’acoustique des casques.

Des accords cadres émergent. Ils visent une bascule fluide du pilote à la flotte. Les clauses de réversibilité et de souveraineté des données pèsent dans chaque contrat. La clarté sur ces points accélère l’adoption.

Cas Atlas Utilities: retour sur investissement

Atlas Utilities prépare des inspections post-tempête. Avec la commande vocale, un superviseur répartit l’essaim sur dix pylônes en moins de trois minutes. Les temps d’accès chutent. Les rapports audio et visuels entrent directement dans l’outil de maintenance.

Après trois mois, l’entreprise observe moins d’aléas de planification et une meilleure sécurité des équipes. La voix agit comme une interface universelle, comprise par les techniciens et les décideurs. Le déploiement valorise aussi la formation existante.

Vers des appareils voix-first

La tendance voix traverse déjà la mobilité. Des prototypes d’appareils à commande vocale sans écran gagnent du terrain dans l’industrie. Ce mouvement rejoint les efforts publics sur l’accessibilité au travail. La maintenance et le secours représentent des terrains naturels.

Si l’innovation tient ses promesses, les services critiques basculeront en mode hybride : voix pour l’orchestration, UI classique pour l’analyse fine. Cette complémentarité réduit la charge cognitive, sans sacrifier la précision. C’est la ligne directrice qui s’impose.

Une fois la viabilité démontrée, la reproductibilité décide du passage à l’échelle. Elle exige des standards, des métriques publiques et des retours partagés.

On en dit quoi ?

La sélection d’OpenAI pour un essai de ruche de drones à commande vocale aux États-Unis marque une étape charnière. La technologie vocalo-conversationnelle rencontre enfin les exigences d’opérations critiques. Les bénéfices sont tangibles, si la sécurité et l’audit restent prioritaires. Le fil à suivre est clair : une innovation utile, mesurée, et centrée sur l’humain.

Pourquoi utiliser la commande vocale pour piloter un essaim de drones ?

Parce qu’elle réduit le temps entre l’intention et l’action, libère les mains de l’opérateur et garde son attention sur la scène. L’IA interprète l’ordre, applique des contraintes de sécurité et renvoie des confirmations courtes.

Comment la sécurité est-elle garantie lors de l’essai ?

Par des garde-fous multiclasse : géo-fences, arrêt d’urgence, détection d’usurpation vocale, latence bornée, et validation humaine des actions sensibles. Les commandes et décisions sont journalisées et auditables.

Quelles sont les limites principales aujourd’hui ?

Le bruit extrême, les pertes réseau longues et les instructions ambiguës restent des défis. Des modes dégradés, une grammaire maîtrisée et l’edge computing atténuent ces risques sans tout résoudre.

Quels secteurs adopteront en premier ?

Les secours, les utilities, la logistique portuaire et l’inspection d’infrastructures. Ces secteurs tirent un gain clair d’une orchestration rapide et traçable via la voix.

Journaliste tech passionné de 38 ans, je décrypte chaque jour l’actualité numérique et j’adore rendre la technologie accessible à tous.